偏導數(partial derivatives)

平常微分時都是只對一個變數微分

但如果要對一個以上變數做微分時

我們就需要用到偏微分法(partial differentiation)

( 數學符號“ ∂ ”, 可讀作「der」、partial 或「偏」)

運算方法

假設現在有兩個變數x和y,

我們分別將x和y視為常數,各自分開微分

<EX>

分別對x和y微分

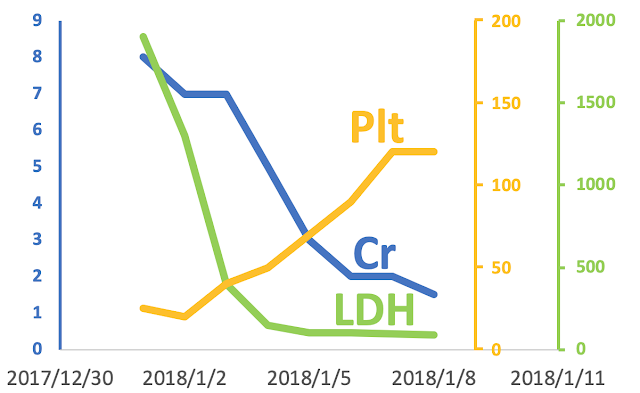

幾何意義

平常只對一個變數微分時,可以想成求一條線之切線斜率

但對兩個變數微分時,我們可以想當曲面固定其中一個變數時,分別求切線斜率

上圖中藍色的部分是我們要微分的曲面

假設我們要對其中的x微分,這時我們固定y值時

可以在這個曲面上得到一條曲線(下圖紅線)(以x & z為軸之平面)

而這時在這條曲線上對x微分,

就可以得到曲線的切線斜率(上圖黑線)

同理,當我們要對其中的y微分,這時我們固定x值時

我們可以得到另外一條曲線 (以y & z為軸之平面)

並且經過微分後得到切線斜率(上圖黑線)

上述兩條黑線就可形成新的平面

而由這平面可得到垂直於平面的法線(下圖藍色箭頭)

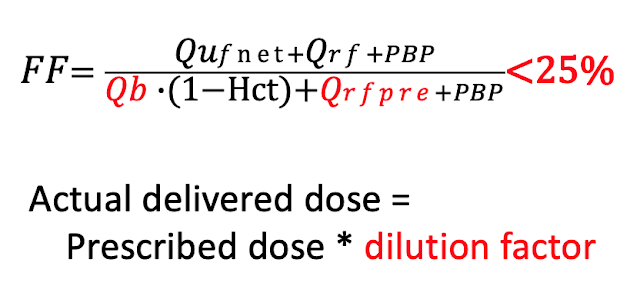

偏微分於機器學習之運用

在機器學習時,我們有時需要用到gradient descent

來求曲面最低點

我們可以想成當以x & z為軸之平面時(η=learning rate)

x' 為原本的x 減掉 “η乘上loss function (即f(x,y)的偏微分)”

經過一次次地靠近,當“η乘上loss function”為零時,即停止

表示到達local minima

而當以y & z為軸之平面時也一樣

y' 為原本的y 減掉 “η乘上loss function (即f(x,y)的偏微分)”

經過一次次地靠近,當“η乘上loss function”為零時,即停止

表示到達local minima

留言

張貼留言